PHILOSOPHY

ユヴァル・ハラリの新刊 『NEXUS』でも焦点に。AIは人間の判断を最適化できるのか

目次

就職活動の面接をAIが行っている。

そんなSFのようなことが今企業で運用され、中国では既にトレンドになっている。

人間の判断はあやふやで、どんなに優秀な面接官であろうと公平なジャッジをくだすことは実は難しい。そうした人の頭脳のあいまいさを排除し、均等かつ最適な判断をAIが下せることは最早周知の事実だろう。

ただし、AIに本当に偏りはないのだろうか?

2025年3月5日に日本語訳の出版が予定されている気鋭の歴史学者ユヴァル・ノア・ハラリの新刊「NEXUS」は、人類と情報の関わりをマクロヒストリーの観点で鋭く炙り出し、こうしたAIの情報取捨の偏りに警鐘を鳴らす。ダニエル・カーネマンらの大ベストセラー「NOISE」やハラリの新刊英語版を先読みし、“判断のAI最適化”の今をのぞいてみよう。

被告人は裁判官が空腹でないことを願うべきだ

AI面接官は、中国でのみ先進的に用いられている技術ではない。2024年にはキリンホールディングスが導入に手を挙げるなど、日本にもその波はすぐに到来するだろう。

「AI面接官」が注目を集めるのは、いかに優れた面接官だろうと、例えば英検の試験官に当たりはずれがあると信じられているようにその採用基準にはバラつきがあるからだ。それはわずかな偏見や思い込み、人種的バイアス、その日の気分が最悪など、些細なことで大きく結果に表れ、本当に企業に”適切”な人材を採用し続けられているかは不明瞭だ。

2021年に出版され世界中でベストセラーになった認知心理学者ダニエル・カーネマンらによる著書「NOISE」は、人間の判断にいかにバラツキがあるかということを白昼の下にさらしている。

例えば裁判は熟練した判事たちが最適な量刑を下すものと考えられているが、実は全くそうではない。1974年に行われた架空の事案を数種類用意し地方裁判官50人に被告人の量刑を決定してもらうという研究では、裁判官の判断が一致するほうが難しく、例えばヘロインの売人には懲役1年から10年の量刑が各々下されるなど、驚くべきばらつきがみられた。20件の事案中16件では、そもそも刑務所に送るか否かの判断が分かれたことは大変ショッキングだ。

現実の裁判官は更に複雑な情報にさらされており、そうしたばらつき(ノイズ)がより大きくなるのは間違いない。例えば多くの裁判官は、一日の始まりと昼食後には寛大な判断を下す傾向にあり、お腹が空いた裁判官は厳しくなる。難民認定申請は暑い日には受理されにくい。命を懸けた申請が天気に左右されてしまうとは、とても恐ろしいことだ。

こうしたノイズにいち早く注目しその危険性について警鐘を鳴らしていた連邦裁判所判事マービン・フランケルは「統計データやチェックリストの活用」が有効だと述べ、「量刑をルールに則って決定する支援としてのコンピュータ」の活用を1970年代にはっきりと支持している。過去データが大量に正確に蓄積されている分野と、AIを用いて判断の最適化を行うというアイディアの融和性の高さは言うまでもない。ただしフランケルは人間による判断を機械に置き換えることは主張していない。

全ての権力がアルゴリズムに集まる

フランケルが示唆したようにAIの活用は人間の判断支援に有効であるが、全てをAIに明け渡す危険性について、私たちは今一度認識しておくべきだ。

人類史を新たな目線で紐解きなおした世界的大ベストセラー「サピエンス全史」の著者、ユヴァル・ノア・ハラリの新刊「NEXUS」はそうした情報と人間の今を鋭く描写し話題になっている。

ハラリが指摘しているのは“AI自体のバイアス”である。

ハラリは大量のデータを集約する力があるAIとそれを監視するために利用する全体主義とに親和性があることに注目している。

「The rise of machine-learning algorithms, however, may be exactly what the Stalins of the world have been waiting for. AI could tilt the technological balance of power in favour of totalitarianism. Indeed, whereas flooding people with data tends to overwhelm them and therefore leads to errors, flooding AI with data tends to make it more efficient. Consequently, AI seems to favour the concentration of in-formation and decision-making in one place.

(機械学習アルゴリズムの台頭は、まさにスターリンのような人物が待ち望んでいたものかもしれない。AIは技術的な権力のバランスを全体主義に有利に傾ける可能性がある。実際、人々にデータを大量に提供すると、それに圧倒され誤りを招くことが多いが、AIにデータを大量に提供するとその効率が向上する。その結果、AIは情報と意思決定を一箇所に集中させる方向に働くようだ。)」「NEXUS」349p、筆者訳

元々情報が個人や企業などで自由にやりとりされ、そこから民衆が自ら取捨選択し判断する民主主義と違い、国家に行き交う全ての情報を機関に集めた上で検閲し再配布する全体主義にとって、大量のデータを取り扱うAIはまさに天から降った宝のように便利なツールなのだ。故に、AIを“神”のような絶対的なものとして妄信することは危険であり、AIそのものが人間のバイアスを受けているという事実に留意し続けなければならない。

現在ビックテックを震撼させている完全オープンソースで無料の中国発AI「DeepSeek」は象徴的だ。ハラリは中国のような人口の多い国かつ政府の政策で個人のプライバシー規制が緩く人口そのままの巨大データを獲得しやすい国は、より精巧なAIアルゴリズムを作り出すことができると記しているが、「DeepSeek」の性能はアメリカをはじめ世界に衝撃を与えるほどだ。

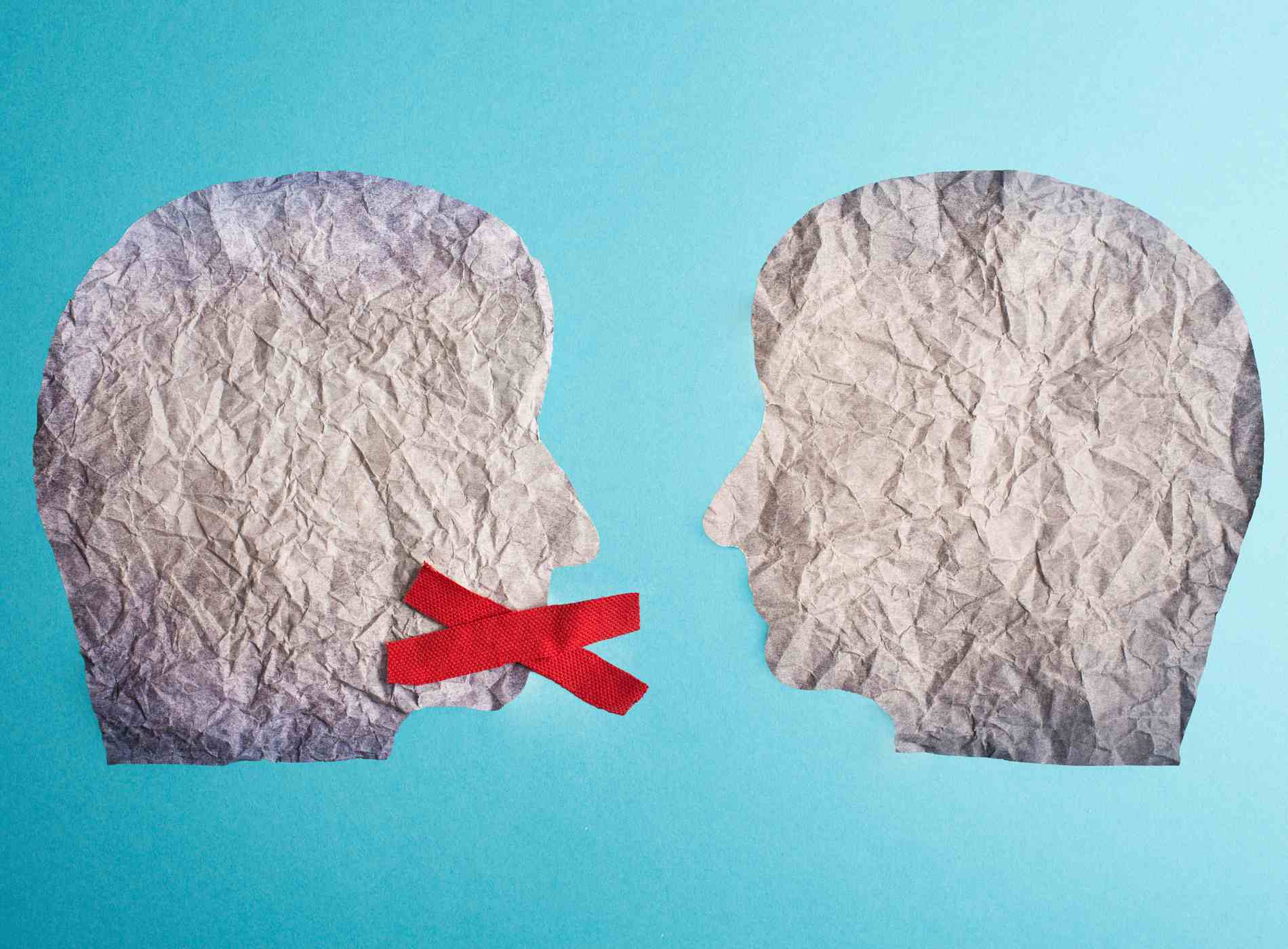

一方で、現在ネットで議論の中心になっているのは、その検閲の厳しさだ。DeepSeek上では、天安門事件の検索はおろか、習近平のXi Jin..以降を表示することすら許容されていないようだ。質問すること自体の自由はまだ保障されているが、AIが表示する内容にそれらタブーワードが数文字表示されるだけで、すぐに「Sorry, that’s beyond my current scope. Let’s talk about something else.」という表示に切り替わってしまう。

しかしながら、今世界はより精巧かつ安価で手に入れられるAIに飢えている。資本主義的利益を追求すれば、どのAIが台頭してゆくだろうか。

これは全体主義だけの話ではなく、例えば冒頭のAI面接官ですら、人間の面接官のデータそのものが偏っている場合、採用する候補者の傾向に企業のニーズによるバイアスは当然のこと、面接官個々人の価値観で育まれたバイアスも反映されることがある。

「The attempt to concentrate all information and power in one place which was the Achilles heel of twentieth-century totalitarianism regimes, might become a decisive advantage in the age of AI. At the same time, as noted in an earlier chapter, AI could also make it possible for totalitarian regimes to establish total surveillance systems that make resistance almost impossible.

(20世紀の全体主義体制においては、情報と権力を一箇所に集中させようとする試みが致命的な弱点だったが、AIの時代においてはそれが決定的な利点となる可能性がある。同時に、前の章で指摘したように、AIは全体主義体制がほぼ抵抗不可能を実現するための完全監視システムを確立することを可能にするだろう。)」「NEXUS」350p、筆者訳

良き教師、良き隣人として

結局のところ、AIをどう私たちの判断に活用してゆくかは、やはり人間の手に委ねられている。

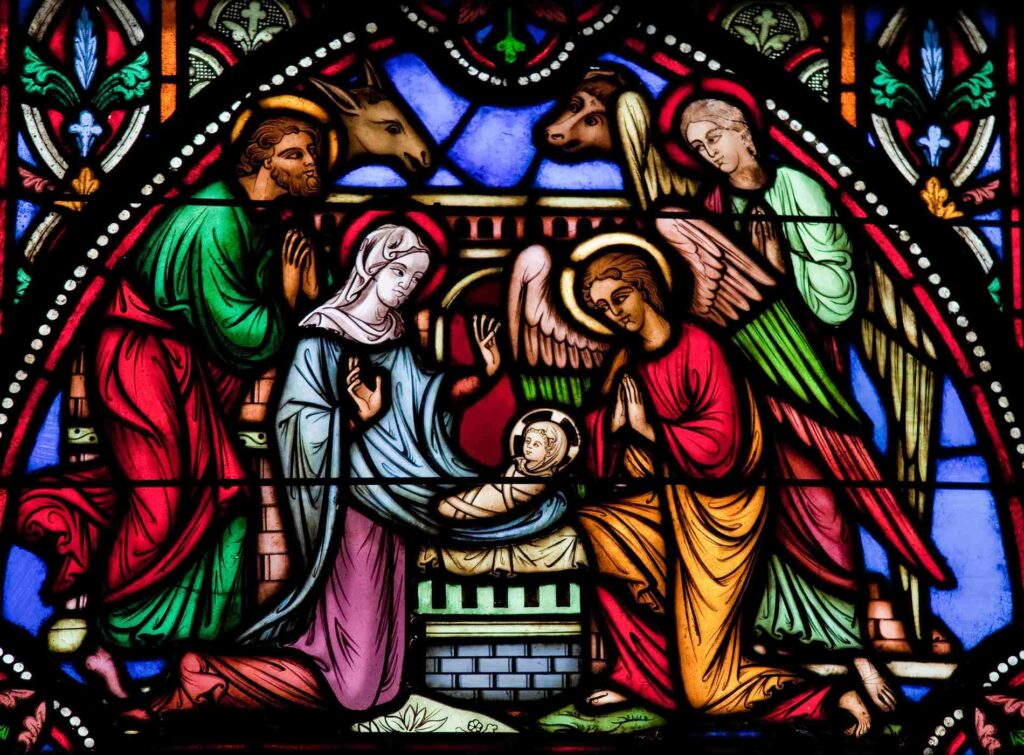

伝説的ドラマシリーズ『スタートレック:ザネクストジェネレーション』で、パトリック・スチュワート演じる艦長であるピカードが、乗組員である人工生命体「データ」に大きな信頼を置いている描写が多々ある。データは人間を遥かに超えた知性を備え、艦が遭遇する様々な未知の問題について、情報という非常に大きな指針を与えてくれる存在だ。

しかしデータは生物について学んでいる途中であり、処刑されそうな乗組員を救う策が無いか悩むピカードに対し「1000人の命よりも一人を?」と一人のために全乗組員の生命を危険にさらす必要があることに驚きを示すなど、人間的な感情やモラルが欠如している場合も多い。

ドラマでは、ピカードはそれを放置せず、データに何故人間はそう判断するかを説明する。データは必要な情報と判断を支援してくれるよき教師であり、発言をたしなめながらお互いに学び合う良き関係を築く必要性を伝えている。

私たちがどこまで自ら選び取り続けることができるか、その中でAIをより効果的に、より良い事へ用いてゆくためにどうしたら良いか、考え続けてゆこう。

参考文献

ダニエル・カーネマン、オリヴィエ・シボニー、キャス・R・サンスティーン「NOISE 上: 組織はなぜ判断を誤るのか?」早川書房、2021年

Yuval Noah Harari,”Nexus: A Brief History of Information Networks from the Stone Age to AI (English Edition)”, Random House, 2024.

『STAR TREK THE NEXT GENERATION』シーズン1第7話「神からの警告(Justice)」

伊藤 甘露

ライター

人間、哲学、宗教、文化人類学、芸術、自然科学を探索する者